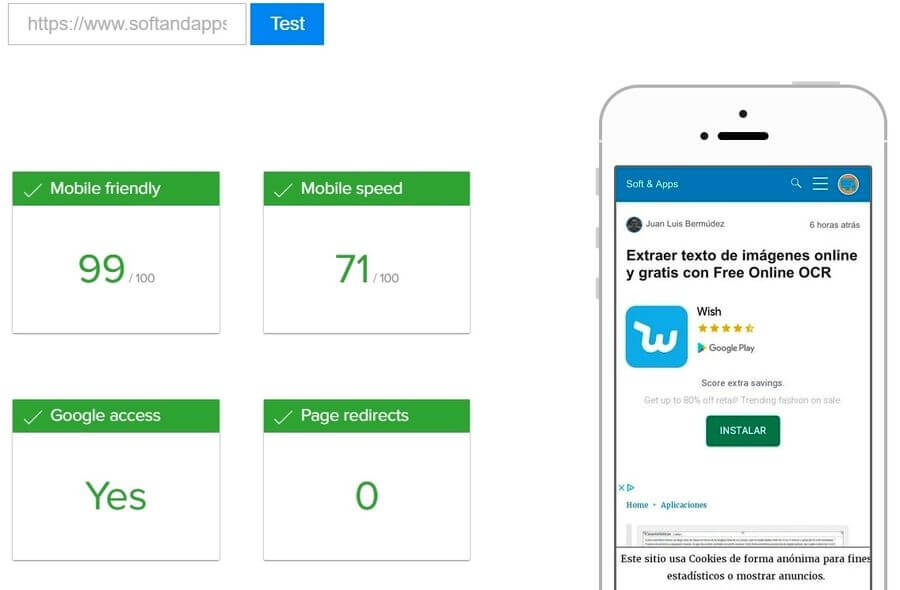

Análisis de SEO móvil gratuito en la página de Varvy

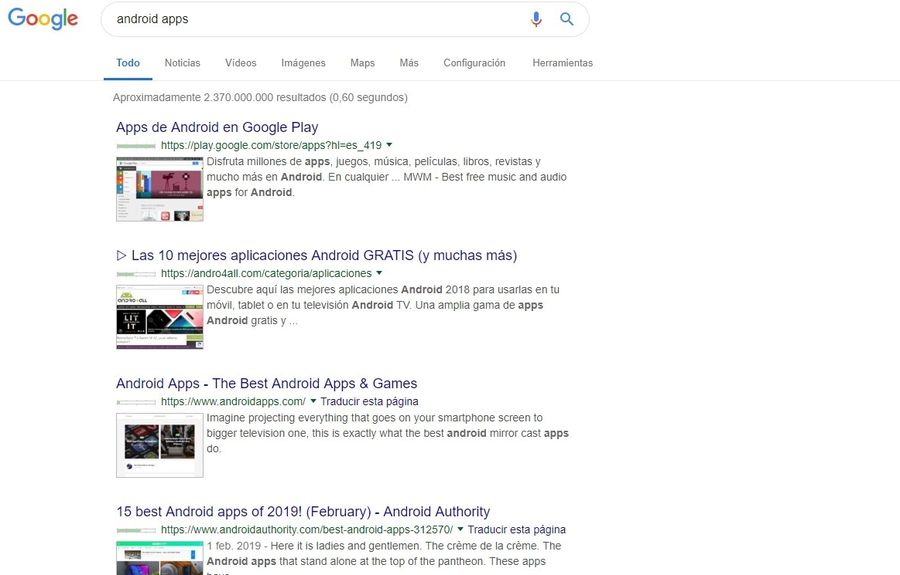

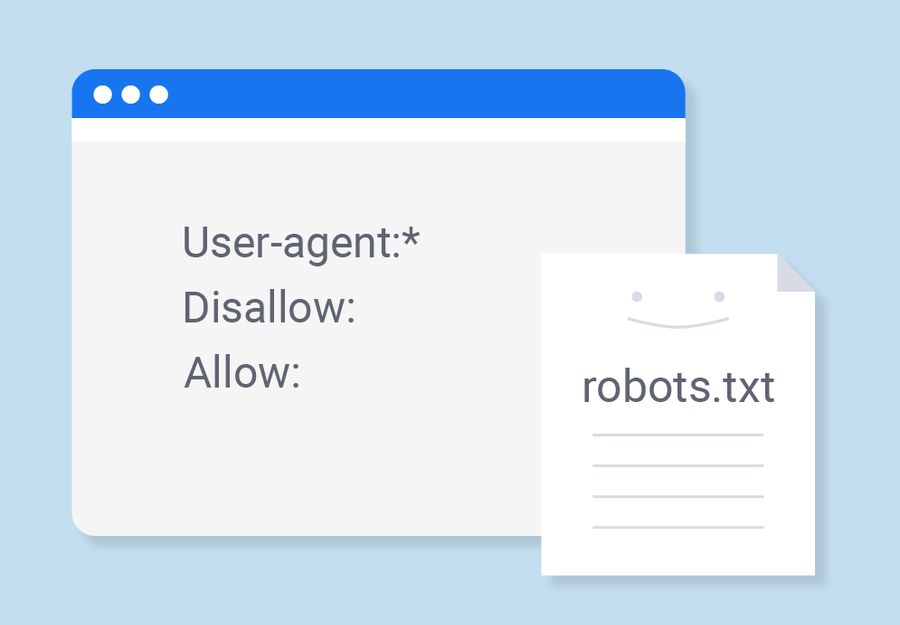

Hoy os presentaré una sencilla herramienta que os puede ser útil para el análisis de SEO móvil de vuestro sitio o de la competencia. Es una herramienta enfocada al SEO On Page, es decir a las optimizaciones que podemos realizar localmente en nuestra página para posicionar mejor. Ya sabrás que Google, también otros buscadores, están … Leer más